NVIDIA HGX: ускоренная серверная платформа для искусственного интеллекта и высокопроизводительных вычислений

|

Суперкомпьютерная платформа NVIDIA HGX для искусственного интеллекта обеспечивает максимальную производительность приложений, работу с огромными наборами данных, сложнейшими моделями и высокопроизводительными вычислениями, благодаря оснащению несколькими графическими процессорами с быстрым межсоединением и ускоренным программным стеком. |

Спецификации NVIDIA HGX

NVIDIA HGX представляет собой платы с 4 / 8 графическими процессорами H100 и 80 ГБ памяти GPU или с видеокартами A100 с памятью 40 или 80 ГБ каждая. Системы с 4 графическими процессорами соединяются с интерфейсом NVIDIA NVLink, а с 8 видеокартами — с коммутатором NVIDIA NVSwitch. Серверная платформа HGX доступна и в форм-факторе PCIe для удобства развертывания и высочайшей вычислительной производительности серверов.

Коммутационная система NVIDIA NVLink позволяет объединить в кластеры до 256 графических процессоров (до 32 шт HGX H100 с 8 графическими процессорами). Технология NVSwitch объединяет 2 платы NVIDIA HGX A100 с 8 графическими процессорами.

Программно-аппаратное решение HGX является основой серверной платформы для искусственного интеллекта. Рассмотрим основные показатели:

|

HGX H100 |

||||

| H100 PCIe | 4 GPU | 8 GPU | 256 GPU | |

| Графические процессоры | 1 NVIDIA H100 PCIe | HGX H100 с 4 GPU | HGX H100 с 8 GPU | 32 узла по 8 NVIDIA H100 SXM, объединенные через NVLink |

| Форм-фактор | PCIe | 4 ускорителя NVIDIA H100 SXM | 8 ускорителей NVIDIA H100 SXM | 16 ускорителей NVIDIA H100 SXM |

| HPC и вычисления для ИИ (FP64/TF32/FP16/INT8) | 48 терафлопс/800 терафлопс/1,6 петафлопс/3,2 петафлопс/3,2 POPS | 240 терафлопс/4 петафлопс/8 петафлопс/16 петафлопс/16 POPS | 480 терафлопс/8 петафлопс/16 петафлопс/32 петафлопс/32 POPS | 15 петафлопс/256 петафлопс/512 петафлопс/1 EF/1 EOPS |

| Память | 80 ГБ на каждом графическом процессоре | До 320 ГБ | До 640 ГБ | До 20 ТБ |

| NVLink | Четвертое поколение | Четвертое поколение | Четвертое поколение | 4 поколение |

| NVSwitch | - | - | Третье поколение | 3 поколение |

| Коммутатор NVLink | - | - | - | 1 поколение |

| Пропускная способность NVSwitсh между графическими процессорами | - | - | 900 ГБ/с | 900 ГБ/с |

| Общая пропускная способность | 900 ГБ/с | 3,6 ТБ/с | 7,2 ТБ/с | 57,6 ТБ/с |

|

|

HGX A100 |

|||

| A100 PCIe | 4 GPU | 8 GPU | 16 GPU | |

| GPU | NVIDIA A100 PCIe | HGX A100 с 4 GPU | HGX A100 с 8 GPU | 2 платформы HGX A100 с 8 GPU |

| Форм-фактор | PCIe | 4 ускорителя NVIDIA A100 SXM | 8 ускорителей NVIDIA A100 SXM | 16 ускорителей NVIDIA A100 SXM |

| HPC и вычисления для ИИ (FP64/TF32/FP16/INT8) | 19,5 терафлопс/312 терафлопс/624 терафлопс/1,2 POPS | 78 терафлопс/1,25 петафлопса/2,5 петафлопса/5 POPS | 156 терафлопс/2,5 петафлопса/5 петафлопс/10 POPS | 312 терафлопс/5 петафлопс/10 петафлопс/20 POPS |

| Память | 80 ГБ на каждом графическом процессоре | До 320 ГБ | До 640 ГБ | До 1280 ГБ |

| NVLink | Третье поколение | Третье поколение | Третье поколение | 3 поколение |

| NVSwitch | - | - | Второе поколение | 2 поколение |

| Пропускная способность NVSwitch между графическими процессорами | - | - | 600 ГБ/с | 600 ГБ/с |

| Общая пропускная способность | 600 ГБ/с | 2,4 ТБ/с | 4,8 ТБ/с | 9,6 ТБ/с |

На сегодняшний день, NVIDIA HGX H100 является мощнейшей серверной платформой для искусственного интеллекта, анализа данных и высокопроизводительных вычислений. Рассмотрим основные комплектации HGX H100.

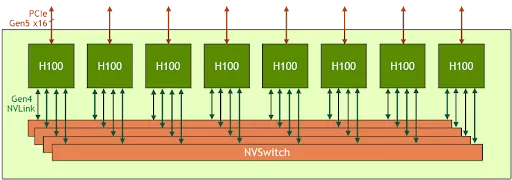

8-GPU HGX H100 представляет собой ключевой строительный блок графического сервера нового поколения Hopper. Он оснащен восемью графическими процессорами H100 Tensor Core и четырьмя NVSwitch третьего поколения. Каждый графический процессор H100 имеет несколько портов NVLink четвертого поколения и подключается ко всем четырем коммутаторам NVSwitch. Каждый NVSwitch представляет собой полностью неблокирующий коммутатор, который полностью соединяет все восемь графических процессоров H100 Tensor Core.

Рисунок 1. Блок-схема высокого уровня HGX H100 с 8 графическими процессорами.

Эта полностью подключенная топология от NVSwitch позволяет любому H100 одновременно взаимодействовать с любым другим H100. Примечательно, что эта связь осуществляется на двунаправленной скорости NVLink 900 гигабайт в секунду (ГБ/с), что более чем в 14 раз превышает пропускную способность текущей шины PCIe Gen4 x16.

NVSwitch третьего поколения также обеспечивает новое аппаратное ускорение для коллективных операций с многоадресной рассылкой и внутрисетевыми сокращениями NVIDIA SHARP. В сочетании с более высокой скоростью NVLink эффективная полоса пропускания для общих коллективных операций искусственного интеллекта. Ускорение коллективов NVSwitch также существенно снижает нагрузку на GPU.

|

|

HGX A100 8-GPU |

HGX H100 8-GPU |

Improvement Ratio |

|

FP8 |

– |

32,000 TFLOPS |

6X (vs A100 FP16) |

|

FP16 |

4,992 TFLOPS |

16,000 TFLOPS |

3X |

|

FP64 |

156 TFLOPS |

480 TFLOPS |

3X |

|

In-Network Compute |

0 |

3.6 TFLOPS |

Infinite |

|

Interface to host CPU |

8x PCIe Gen4 x16 |

8x PCIe Gen5 x16 |

2X |

|

Bisection Bandwidth |

2.4 TB/s |

3.6 TB/s |

1.5X |

Таблица 1. Сравнение HGX A100 с 8 графическими процессорами и новым HGX H100 с 8 графическими процессорами

Развивающийся класс экзафлопсных моделей искусственного интеллекта с триллионом параметров для таких задач, как точный диалоговый искусственный интеллект, требует месяцев обучения, даже на суперкомпьютерах. Чтобы сократить это до скорости бизнеса и завершить обучение за несколько часов, требуется высокоскоростная и бесперебойная связь между каждым графическим процессором в кластере серверов.

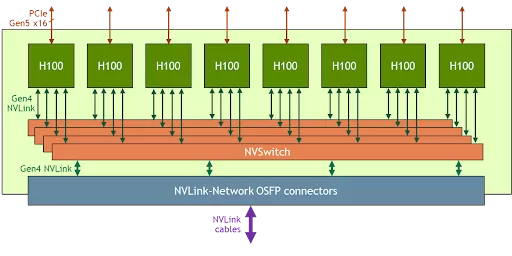

Для решения этих крупных задач созданы новые NVLink и NVSwitch, которые позволяют HGX H100 с 8 графическими процессорами масштабироваться и поддерживать гораздо более крупный домен NVLink с помощью новой сети NVLink. Другая версия HGX H100 с 8 графическими процессорами оснащена новой поддержкой сети NVLink.

Рисунок 2. Блок-схема высокого уровня HGX H100 с 8 графическими процессорами и поддержкой сети NVLink.

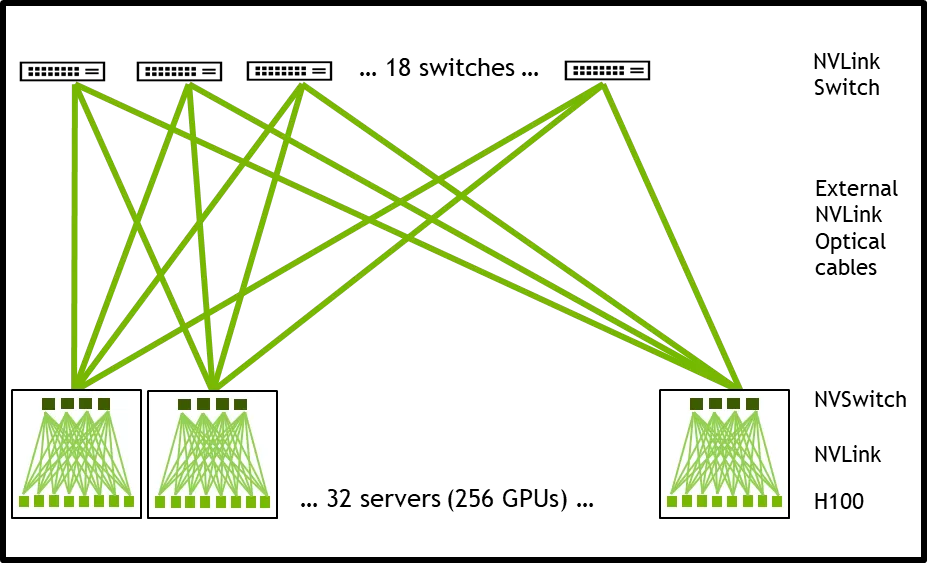

Системные узлы, построенные на базе 8-GPU HGX H100 с поддержкой сети NVLink, могут полностью подключаться к другим системам через подключаемые кабели LinkX Octal Small Form Factor Pluggable (OSFP) и новый внешний коммутатор NVLink. Это соединение позволяет использовать до 256 доменов NVLink графического процессора. На рис. 3 показана топология кластера.

Рис. 3. Блок графического процессора 256 H100

|

|

256 A100 GPU Pod |

256 H100 GPU Pod |

Improvement Ratio |

|

NVLINK Domain |

8 GPU |

256 GPU |

32X |

|

FP8 |

– |

1,024 PFLOPS |

6X (vs A100 FP16) |

|

FP16 |

160 PFLOPS |

512 PFLOPS |

3X |

|

FP64 |

5 PFLOPS |

15 PFLOPS |

3X |

|

In-Network Compute |

0 |

192 TFLOPS |

Infinite |

|

Bisection Bandwidth |

6.4 TB/s |

70 TB/s |

11X |

Таблица 2. Сравнение блока графического процессора 256 A100 и модуля графического процессора 256 H100

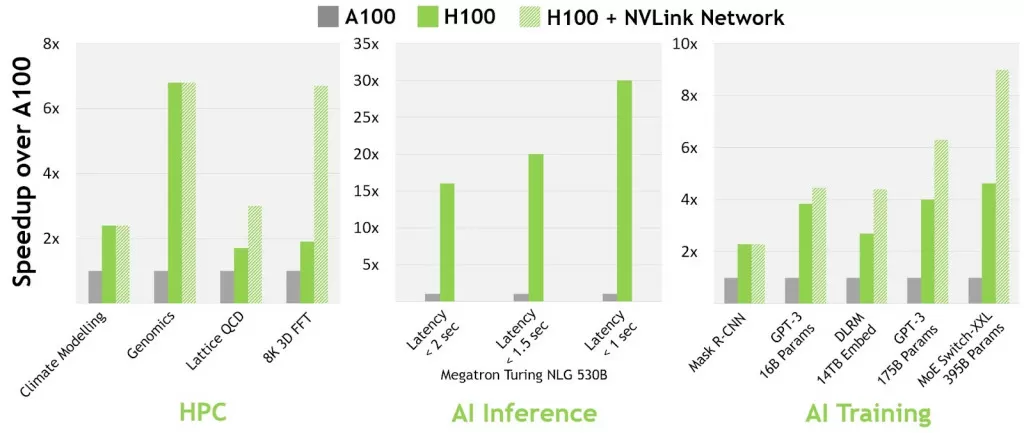

Благодаря резкому увеличению вычислительных и сетевых возможностей HGX H100 производительность приложений искусственного интеллекта и высокопроизводительных вычислений значительно улучшилась.

Сегодняшняя основная модель искусственного интеллекта и высокопроизводительных вычислений может полностью размещаться в совокупной памяти графического процессора одного узла. Например, BERT-Large, Mask R-CNN и HGX H100 являются наиболее эффективными решениями для обучения.

Для более продвинутой и крупной модели искусственного интеллекта и высокопроизводительных вычислений требуется наличие нескольких узлов совокупной памяти графического процессора. Например, рекомендательная модель глубокого обучения (DLRM) с терабайтами встроенных таблиц, модель обработки естественного языка с участием большого числа экспертов (MoE) и HGX H100 с сетью NVLink ускоряют устранение ключевых узких мест в коммуникации и являются лучшим решением. для этого класса нагрузки.

На рис. 4 из технического документа по архитектуре графического процессора NVIDIA H100 показано дополнительное повышение производительности, обеспечиваемое сетью NVLink.

Рисунок 4. Прирост производительности приложения при сравнении различных конфигураций системы

Все показатели производительности являются предварительными и основаны на текущих ожиданиях и могут быть изменены при поставке продуктов. Кластер A100: сеть HDR IB. Кластер H100: сеть NDR IB с сетью NVLink, где указано.

# Графические процессоры: Climate Modeling 1K, LQCD 1K, Genomics 8, 3D-FFT 256, MT-NLG 32 (размеры пакетов: 4 для A100, 60 для H100 за 1 секунду, 8 для A100 и 64 для H100 за 1,5 и 2 секунды), МРЦНН 8 (партия 32), ГПТ-3 16Б 512 (партия 256), ДЛРМ 128 (партия 64К), ГПТ-3 16К (партия 512), МО 8К (партия 512, по одному эксперту на ГПУ)

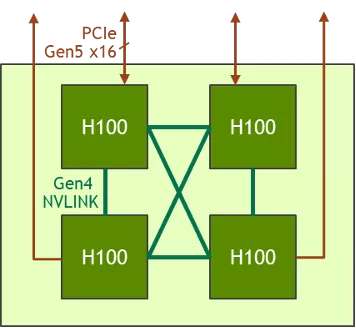

В дополнение к версии с 8 графическими процессорами в семействе HGX также имеется версия с 4 графическими процессорами, которая напрямую связана с NVLink четвертого поколения.

Рисунок 5. Блок-схема высокого уровня HGX H100 с 4 графическими процессорами.

Пропускная способность NVLink «точка-точка» H100-H100 составляет 300 ГБ/с в двустороннем направлении, что примерно в 5 раз быстрее, чем у современной шины PCIe Gen4 x16.

Форм-фактор HGX H100 с 4 графическими процессорами оптимизирован для плотного развертывания HPC:

· Несколько 4-GPU HGX H100 можно разместить в системе жидкостного охлаждения высотой 1U, чтобы максимизировать плотность графических процессоров в стойке.

· Полностью безпереключательная архитектура PCIe с 4 графическими процессорами HGX H100 напрямую подключается к ЦП, что снижает затраты на системные материалы и экономит электроэнергию.

· Для рабочих нагрузок, требующих более интенсивного использования ЦП, HGX H100 с 4 графическими процессорами может работать в паре с двумя разъемами ЦП, чтобы увеличить соотношение ЦП и ГП для более сбалансированной конфигурации системы.

Bouz Group предлагает к поставке серверы на платформе NVIDIA HGX надежных брендов: ASUS, Supermicro, Gigabyte. Вы можете купить серверы для искусственного интеллекта HGX H100 или A100 с доставкой по России по самым выгодным ценам, технические специалисты Bouz Group помогут с подбором необходимого оборудования.